Arich Lawson | Belle foto

Con la maggior parte dei programmi per computer, anche quelli complessi, puoi approfondire per trovare il codice e l’utilizzo della memoria. Perché Quel programma produce un comportamento o un output specifico. Questo in genere non è vero nel campo dell’intelligenza artificiale, dove le inspiegabili reti neurali alla base di questi modelli, ad esempio, rendono difficile anche per gli esperti individuare esattamente il motivo per cui spesso confondono le informazioni.

Ora, Nuove ricerche dall’antropologia Claude offre una nuova finestra su ciò che accade nella “scatola nera” del LLM. della compagnia Nuova carta “Extracting Interpretable Features from a Clad 3 Sonnet” descrive un nuovo potente metodo per spiegare parzialmente come i milioni di neuroni artificiali di un modello si attivano per produrre risposte sorprendentemente realistiche a domande comuni.

Apertura del cofano

Quando si analizza un LLM, è banale vedere quali specifici neuroni artificiali vengono attivati in risposta a quale query specifica. Ma gli LLM non memorizzano semplicemente parole o concetti diversi in un singolo neurone. Invece, come spiegano gli antropologi, “ogni concetto è rappresentato da più neuroni, e ogni neurone è coinvolto nella rappresentazione di più concetti”.

Un sistema per risolvere questo pasticcio uno-a-molti e molti-a-uno Codificatori automatici sparsi e può essere utilizzato per eseguire calcoli complessi Un algoritmo di “apprendimento del dizionario”. attraverso il modello. Questa procedura evidenzia quali gruppi di neuroni sono attivati in modo più coerente per parole specifiche che compaiono in vari stimoli testuali.

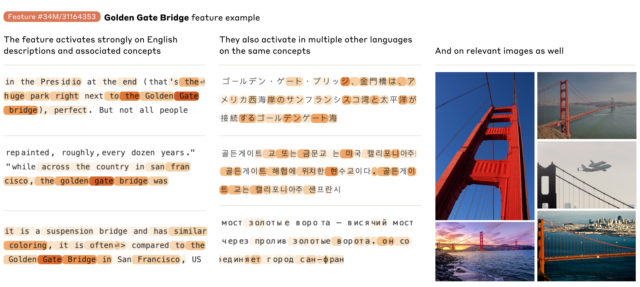

Questi schemi neuronali multidimensionali vengono quindi chiamati “caratteristiche” associate a determinate parole o concetti. Queste caratteristiche includono qualsiasi cosa, dai semplici nomi formali come Golden Gate Bridge Per concetti più concisi come Errori di programmazione O funzione di addizione Rappresentare lo stesso concetto nel codice informatico e in più linguaggi e modalità di comunicazione (ad esempio, testo e immagini).

UN Ottobre 2023 Rassegna antropologica È stato dimostrato che questo processo di base funziona su modelli di giocattoli molto piccoli a un solo strato. I nuovi misuratori di carta dell’azienda sono stati migliorati per identificare le decine di migliaia di funzionalità attive sul suo modello Clad 3.0 Sonata di medie dimensioni. La mappa delle caratteristiche risultante: puoi Studio di zona“Crea una mappa concettuale approssimativa [Claude’s] I ricercatori scrivono che i livelli interni sono “a metà del suo calcolo” e “riflettono la profondità, l’ampiezza e l’astrazione delle capacità avanzate di Sonnet”. ” Potrebbe essere “un ordine di grandezza” più piccolo di una mappatura completa del clade 3. .

Anche a livello superficiale, sfogliare questa mappa delle caratteristiche aiuta a mostrare come determinate parole chiave, frasi e concetti si collegano alla conoscenza approssimativa. UN La funzione denominata “Maiuscole”, Ad esempio, le parole “capitale” tendono ad avere un buon rendimento, ma vengono menzionati anche nomi di città specifiche come Riga, Berlino, Azerbaigian, Islamabad e Montpelier, Vermont, per citarne alcuni.

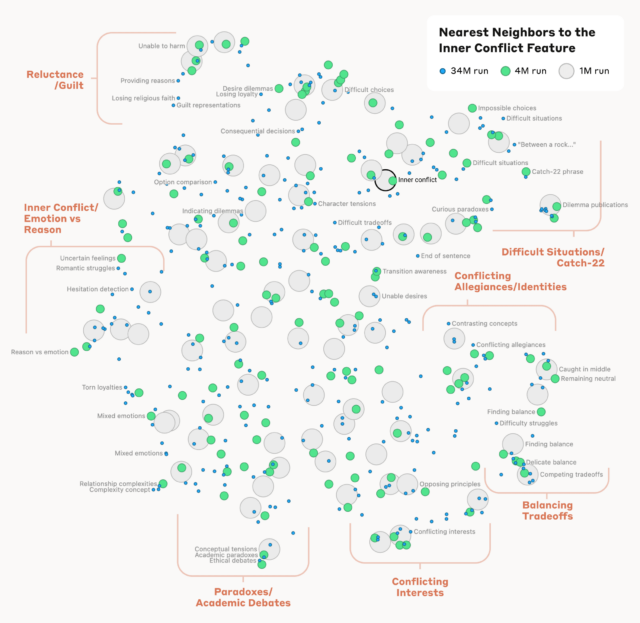

Lo studio calcola anche una misura matematica di “distanza” basata sulla somiglianza neurale di diverse caratteristiche. Questo processo si traduce in “quartieri di caratteristiche” che sono “spesso organizzati in gruppi geometricamente correlati che condividono una relazione semantica”, scrivono i ricercatori, aggiungendo che “l’organizzazione interna dei concetti in un modello di intelligenza artificiale assomiglia, almeno in una certa misura, al nostro essere umano”. concetti di somiglianza.” Ad esempio, il film sul Golden Gate Bridge è relativamente “intimo” con caratteristiche che descrivono “l’isola di Alcatraz, Girardelli Square, i Golden State Warriors, il governatore della California Gavin Newsom, il terremoto del 1906 e un film di Alfred Hitchcock ambientato a San Francisco”. Vertigine.”

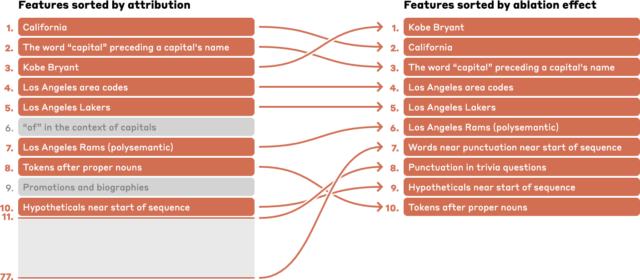

L’identificazione di caratteristiche LLM specifiche può aiutare i ricercatori a mappare la catena di inferenza utilizzata dal modello per rispondere a domande complesse. Ad esempio, un annuncio relativo a “Capitale dello stato in cui Kobe Bryant ha giocato a basket” mostra l’attività in una catena di funzionalità correlate a “Kobe Bryant”, “Los Angeles Lakers”, “California”, “Capitali” e “Sacramento”. ”, per citarne alcuni, calcolati per avere un effetto maggiore sui risultati.